在《在Kafka中使用Avro编码消息:Producter篇》 和 《在Kafka中使用Avro编码消息:Consumer篇》 两篇文章里面我介绍了直接使用原生的 Kafka API生成和消费 Avro 类型的编码消息,本文将继续介绍如何通过 Spark 从 Kafka 中读取这些 Avro 格式化的消息。如果想及时了解Spark、Hadoop或者Hbase相关的文章,欢迎关注微信公共帐号:iteblog_hadoop其 zz~~ 7年前 (2017-09-26) 4773℃ 0评论19喜欢

我在《在Kafka中使用Avro编码消息:Producter篇》文章中简单介绍了如何发送 Avro 类型的消息到 Kafka。本文接着上文介绍如何从 Kafka 读取 Avro 格式的消息。关于 Avro 我这就不再介绍了。如果想及时了解Spark、Hadoop或者Hbase相关的文章,欢迎关注微信公共帐号:iteblog_hadoop从 Kafka 中读取 Avro 格式的消息从 Kafka 中读取 Avro 格式的消 w397090770 7年前 (2017-09-25) 6444℃ 0评论16喜欢

本文将介绍如何在 Kafka 中使用 Avro 来序列化消息,并提供完整的 Producter 代码共大家使用。AvroAvro 是一个数据序列化的系统,它可以将数据结构或对象转化成便于存储或传输的格式。Avro设计之初就用来支持数据密集型应用,适合于远程或本地大规模数据的存储和交换。因为本文并不是专门介绍 Avro 的文章,如需要更加详细地 zz~~ 7年前 (2017-09-22) 7161℃ 2评论23喜欢

关系运算1、等值比较: =语法:A=B操作类型:所有基本类型描述: 如果表达式A与表达式B相等,则为TRUE;否则为FALSE[code lang="sql"]hive> select 1 from iteblog where 1=1;1[/code]2、不等值比较: 语法: A B操作类型: 所有基本类型描述: 如果表达式A为NULL,或者表达式B为NULL,返回NULL;如果表达式A与表达式B不相等,则为TRUE;否则为 zz~~ 7年前 (2017-09-14) 94132℃ 3评论183喜欢

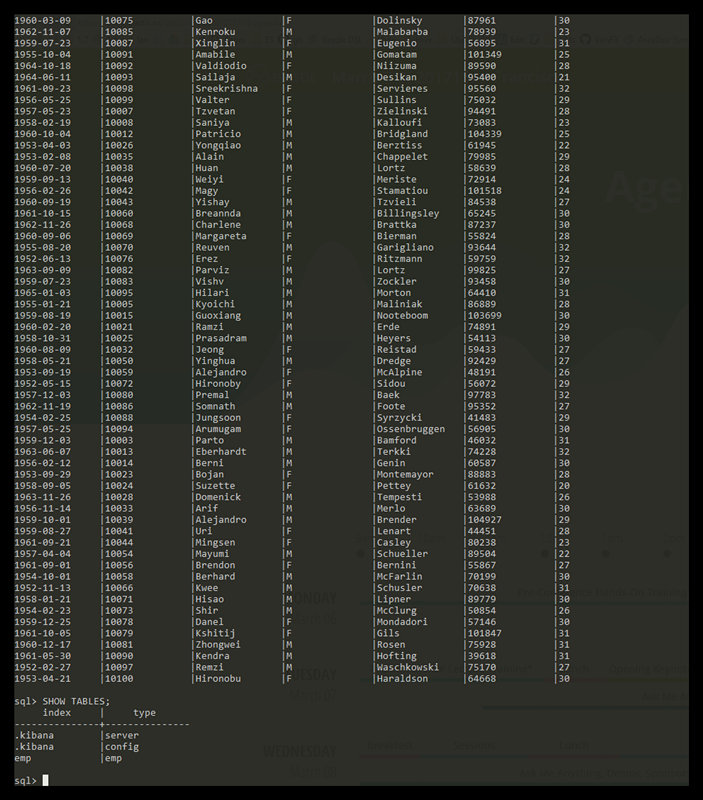

告诉大家一件好消息:ElasticSearch官方正在开发SQL功能模块,也就是说未来版本(不是 6.x 就是 7.x)的Elasticsearch内置就支持SQL特性了!这样我们就不需要安装 NLPchina/elasticsearch-sql 插件。这个SQL模块是属于X-Pack的一部分。首先默认提供了一个 CLI 工具,可以很方便的执行 SQL 查询。如下图如果想及时了解Spark、Hadoop或者Hbase相关的 w397090770 7年前 (2017-09-06) 3105℃ 0评论14喜欢

2017年08月31日发布了ElasticSearch 6.0.0-beta2,其中有很多特性值得期待:稀疏性 Doc Values 的支持:大家知道 es 的 doc values 是列式存储,文档的原始值都是存放在 doc values 里面的,而稀疏性是指,一个索引里面,文档的结构其实是多样性的,但是郁闷的是只要一个文档有这个字段,其他所有的文档尽管没有这个字段,可也都要承担这个 w397090770 7年前 (2017-09-04) 9176℃ 0评论22喜欢

使用 ElasticSearch 我们可以构建一个功能完备的搜索服务器。这一切实现起来都很简单,本文将花五分钟向你介绍如何实现。安装和运行Elasticsearch这篇文章的操作环境是 Linux 或者 Mac,在安装 ElasticSearch 之前,确保你的系统上已经安装好 JDK 6 或者以上版本。[code lang="bash"]wget https://download.elastic.co/elasticsearch/elasticsearch/elasticsearc w397090770 8年前 (2017-09-01) 3229℃ 0评论13喜欢

《Apache Kafka消息格式的演变(0.7.x~0.10.x)》《图解Apache Kafka消息偏移量的演变(0.7.x~0.10.x)》《Kafka消息时间戳及压缩消息对时间戳的处理》本博客的《Apache Kafka消息格式的演变(0.7.x~0.10.x)》文章中介绍了 Kafka 各个版本的格式变化。其中 Kafka 0.10.x 消息的一大变化是引入了消息时间戳的字段。本文将介绍 Kafka 消息引入时间戳的必要性 w397090770 8年前 (2017-09-01) 7641℃ 0评论23喜欢